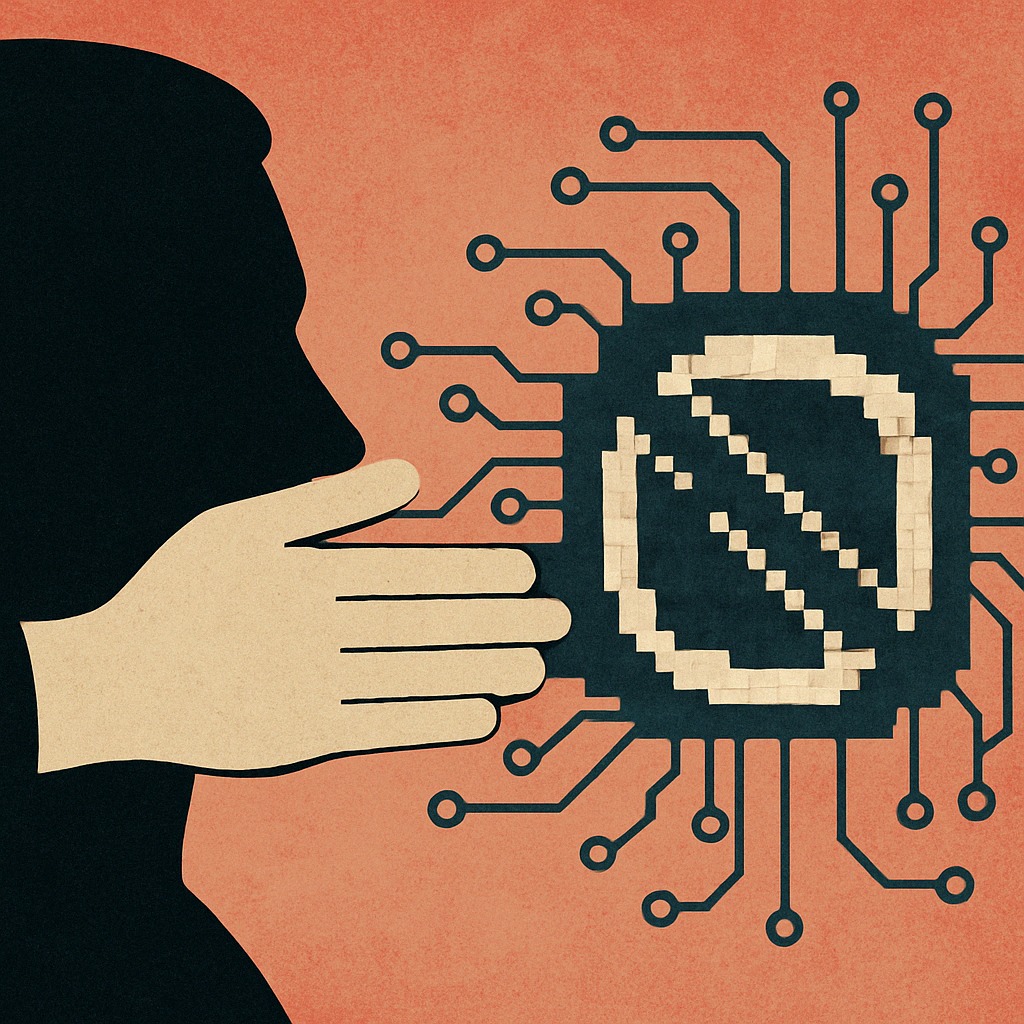

Vivere (e creare) sotto sorveglianza

Oggi non serve più bruciare i libri in piazza per silenziare una voce scomoda.

La censura ha cambiato pelle. Non ti arresta, non ti vieta formalmente nulla.

Semplicemente ti spegne.

Un post non viene bannato, ma dimenticato.

Un video non viene rimosso, ma nascosto.

Un pensiero non viene vietato, ma reso invisibile.

È così che lavora l’algoritmo.

Decide cosa merita attenzione e cosa no. Premia ciò che è conforme, penalizza ciò che interroga, sovverte, rompe gli schemi.

E nel farlo, non solo limita la libertà di espressione: modella il desiderio, l’estetica, il discorso pubblico.

Censura: una parola antica per un potere sempre nuovo

Il termine “censura” ha origini antiche e insospettabilmente istituzionali.

Nasce nella Roma del IV secolo a.C., dove il censore era una figura pubblica incaricata di compilare i registri dei cittadini, sovrintendere al decoro della vita pubblica e, soprattutto, valutare la moralità dei comportamenti.

Aveva il potere di escludere senatori e cavalieri se li riteneva indegni: non per ciò che avevano fatto, ma per ciò che erano diventati agli occhi dello Stato.

Ma i censori non sono una peculiarità romana.

Ogni civiltà ha sviluppato le proprie forme di sorveglianza morale, affidandole ora al potere religioso, ora a quello politico.

Dai tribunali dell’Inquisizione alle autorità rabbiniche, dai codici morali delle caste indiane ai consigli confessionali protestanti, tutte le culture hanno delegato a un consesso di pari il compito di custodire e correggere la morale pubblica.

Che fossero chierici, giudici o notabili, sempre di guardiani del costume si trattava.

Nel tempo, la forma cambia ma la funzione resta.

Dalle liste nere del maccartismo alle black list dei social media, il potere ha sempre avuto bisogno di censurare — e di farlo in nome di una morale.

Quella morale, però, non è mai neutra: è storicamente determinata, culturalmente costruita, economicamente utile a qualcuno.

La censura oggi e il ruolo degli algoritmi

Nel mondo contemporaneo, la censura ha smesso di avere il volto autoritario del divieto esplicito.

Non ti vieta di parlare. Semplicemente non ti fa ascoltare.

Non ci sono più roghi pubblici, ma silenzi algoritmici.

Non ti si chiude la bocca, ma ti si toglie di mezzo.

I contenuti non vengono negati, vengono sepolti.

Sei ancora online, ma non esisti più per nessuno.

È questa la nuova frontiera della censura: l’invisibilità sistemica.

Un processo automatico, opaco e silenzioso, in cui il potere decisionale non è più esercitato da una figura istituzionale, ma da un calcolo statistico.

È l’algoritmo che stabilisce cosa viene visto, quanto, da chi, e con quale priorità.

E nel farlo, finisce per normalizzare non solo l’accesso all’informazione, ma i criteri stessi del desiderio, del pensiero e della legittimità sociale.

Eppure, nonostante il potere che esercita, l’algoritmo è stupido.

Opera per riconoscimento di pattern, parole chiave, associazioni predittive. Non comprende il contesto, non sa distinguere tra pornografia e educazione sessuale, tra denuncia e incitamento, tra satira e disinformazione.

È un filtro cieco, incapace di cogliere la complessità del discorso.

La sua “neutralità” tecnica diventa un’arma contro tutto ciò che è ambiguo, fluido, non normato.

Questo tipo di censura non è neutrale.

Le piattaforme non sono “solo” strumenti: sono ambienti ideologici.

I valori che muovono i loro filtri sono incorporati nel codice e rispondono a interessi precisi: profitto, controllo, consenso.

Algoritmo, in questo scenario, non è una tecnologia: è una forma di potere.

Shadowban: parlare nel vuoto

Non c’è avviso, non c’è notifica. Non vieni bannato, vieni tolto dalla vista.

Quello che scrivi è ancora lì, ma non appare nel feed. I tuoi follower non ricevono più aggiornamenti. Le interazioni crollano.

Non sai perché. Non sai quando. Non sai per quanto.

Questa è la logica dello shadowban: una forma di censura algoritmica in cui non vieni rimosso, ma silenziato. Una messa al margine digitalmente gestita, senza prove, senza dialogo, senza appello.

Succede continuamente a creator queer, attivistə, educatori sessuali, artisti indipendenti, lavoratorə che denunciano abusi o discriminazioni.

Succede anche a chi tratta temi delicati in modo serio, rispettoso, costruttivo.

Succede perché l’algoritmo non è progettato per tutelare la complessità, ma per premiare ciò che è facilmente monetizzabile.

E così, contenuti che parlano di educazione affettiva, di identità di genere, di sessualità consapevole o di giustizia sociale diventano “problematici”.

Non perché violano le regole, ma perché disturbano il sistema commerciale che regola la visibilità.

Lo shadowban non ti punisce per ciò che fai, ma per ciò che potresti rappresentare: una voce che non si allinea, un corpo che non si conforma, una narrazione che non si vende bene.

È come urlare in una stanza insonorizzata.

E il silenzio che ne segue non è solo digitale. È politico.

Sessualità e social media: la censura dei corpi, delle parole, dei significati

Tra i bersagli preferiti della censura algoritmica, la sessualità occupa un posto d’onore.

Non quella mercificata, iper-patinata, conforme al desiderio maschile eteronormato — quella passa, anzi spesso viene premiata.

Ma quella reale, incarnata, complessa, fatta di identità, di esplorazione, di relazioni affettive, di esperienze educative…

quella viene penalizzata.

I social media sono diventati nel tempo uno dei pochi spazi accessibili dove fare educazione sessuale e affettiva in maniera libera, peer-to-peer, non mediatizzata.

Educatorə, psicologə, creator, operatorə della salute sessuale hanno costruito comunità, prodotto risorse, aperto conversazioni importanti — spesso gratuitamente.

Eppure oggi, quell’impegno viene sistematicamente sabotato.

Basta una parola nel posto sbagliato — sex, body, orgasm, consent — per finire in shadowban.

Basta un post illustrato, un’infografica, una riflessione personale che tocchi il desiderio o l’identità, per essere segnalati, penalizzati, resi invisibili.

Per continuare a lavorare, moltə sono costrettə a usare codici e linguaggi cifrati: “s3x”, “eduk@zione”, “b0dyp0sitive”, oppure emoji sostitutive.

Una neolingua necessaria per sopravvivere, ma che stravolge il linguaggio, confonde il discorso, isola le persone.

Nel frattempo, le stesse piattaforme che censurano contenuti educativi tollerano molestie, insulti e pornografia non consensuale.

Le creatrici femminili sono esposte a minacce e sessismo sistematico.

I creator maschili queer vengono ignorati, resi invisibili, privati di ogni possibilità di monetizzazione.

E quando le segnalazioni arrivano, nessuno risponde.

Il risultato?

Un panorama sempre più spoglio, silenzioso, in cui le voci critiche si stancano e smettono di parlare.

In cui fare educazione sessuale diventa faticoso, frustrante, e alla lunga insostenibile.

Pandemia, lavoro sessuale e il paradosso della visibilità

Durante la pandemia, i social media sono diventati spazio vitale.

Per moltə, l’unico spazio disponibile.

Il distanziamento ha reso impossibili le attività in presenza, e così educatorə, sessuologə, performer, sex worker, attivistə hanno trasferito il proprio lavoro online.

Per alcuni mesi, la rete è sembrata un luogo di possibilità, dove raccontare i corpi senza filtri e senza intermediari, dove riappropriarsi della sessualità fuori dai codici commerciali.

Ma quella libertà è durata poco.

Appena i contenuti hanno iniziato a raggiungere numeri significativi, l’algoritmo ha reagito.

I profili sono stati silenziati, le pagine rimosse, le interazioni crollate.

Account educativi, artistici, collettivi queer, iniziative mutualistiche sono stati trattati alla stregua di spam o contenuti per adulti.

E tutto questo senza avviso, senza possibilità di replica, senza tutela.

Alcuni casi emblematici:

- l’account di Strippers United, organizzazione no-profit a supporto delle lavoratrici del settore, rimosso da Instagram senza spiegazioni.

- creator di sex toys artigianali bannati da Etsy per “violazione delle linee guida”, nonostante si trattasse di prodotti legali.

- campagne educative LGBTQ+ oscurate per “contenuti sensibili”, mentre video misogini o violenti continuavano a prosperare.

Nel frattempo, banche e circuiti di pagamento hanno iniziato a rifiutare transazioni legate al lavoro sessuale, anche quando legale.

Molti CMS hanno vietato l’apertura di sexy shop, le piattaforme pubblicitarie hanno escluso interi settori.

Il messaggio è chiaro: puoi esistere, ma non puoi guadagnare.

Puoi parlare, ma non puoi farlo a voce alta.

Puoi lavorare, ma solo se non disturbi l’estetica dominante.

La doppia morale delle piattaforme: chi può desiderare?

Il paradosso è evidente.

Mentre educatorə sessuali vengono penalizzatə per un’infografica sul consenso o una riflessione sull’identità, grandi marchi come Playboy continuano a pubblicare senza alcuna restrizione.

Le immagini di corpi femminili ipersessualizzati passano. Le pubblicità ammiccanti passano. Le “campagne audaci” pensate da uomini cisgender per un pubblico maschile, passano.

Perché?

Perché sono aziende, generano profitto, aderiscono a un’estetica accettabile, controllata, facilmente vendibile.

Non disturbano l’ordine del discorso dominante: lo rafforzano.

Invece, chi crea contenuti dal basso, spesso con strumenti precari e senza mediazioni commerciali, viene considerato pericoloso.

Non per ciò che mostra, ma per ciò che rappresenta:

- la possibilità di raccontare il sesso da un punto di vista queer, disabile, nero, grasso, dissidente

- la libertà di parlare di piacere fuori dal patriarcato

- la capacità di creare comunità non gerarchiche, non filtrate, non monetizzabili in modo lineare

In questo scenario, la censura non colpisce solo i contenuti, ma anche le soggettività che li producono.

Non è solo un problema di parole, ma di corpi. Di chi parla, da dove, per chi, e con quale autorizzazione simbolica.

Chi ha il potere di essere ascoltato? Chi ha il diritto di desiderare pubblicamente?

È qui che l’algoritmo smette di essere un filtro neutro e diventa un agente attivo di normalizzazione culturale.

Quando l’algoritmo amplifica la misoginia

Mentre i contenuti educativi vengono silenziati o penalizzati, l’algoritmo premia e spinge materiali violenti, sessisti, misogini.

Non perché li approvi in modo consapevole, ma perché funzionano: generano reazioni forti, aumentano il tempo di permanenza, creano polarizzazione e quindi traffico.

E il traffico, come sappiamo, è denaro.

In Inghilterra, una ricerca condotta dalla University College London insieme all’Università del Kent ha rivelato che gli adolescenti ricevono contenuti misogini fino a quattro volte più spesso di contenuti legati all’educazione sessuale corretta.

Gli algoritmi, lasciati liberi di “ottimizzare”, finiscono per trasformare l’intrattenimento in una catena di radicalizzazione silenziosa.

Video che ridicolizzano le donne, ne negano l’autonomia, legittimano molestie e stereotipi tossici vengono presentati come “meme”, “sketch”, “opinioni alternative”.

Ma per un pubblico giovane, senza filtri critici ancora sviluppati, quel contenuto diventa realtà, identità, valore.

I docenti intervistati nello studio parlano di una vera e propria mutazione della cultura scolastica, dove il disprezzo per le donne viene normalizzato, minimizzato, addirittura difeso.

La misoginia non è più una deviazione: è un trend.

E mentre questo accade, gli educatori che provano a contrastare la narrazione dominante restano invisibili, soffocati dalle restrizioni, demonetizzati, soli.

La censura non agisce in modo neutro.

Costruisce uno squilibrio.

E in quello squilibrio si forma la coscienza dei futuri adulti.

Il corpo delle donne tra censura e mercificazione

Per secoli il corpo femminile è stato raccontato attraverso lo sguardo maschile: oggetto del desiderio, superficie simbolica, strumento narrativo.

Mai soggetto, mai narratore.

Internet, almeno in teoria, ha rappresentato una svolta.

Per la prima volta, le donne potevano mostrarsi secondo i propri codici, autorappresentarsi, parlare di sessualità in prima persona — non per piacere a qualcuno, ma per esistere.

Eppure, anche qui, l’illusione è durata poco.

Oggi l’algoritmo penalizza sistematicamente la nudità femminile, anche quando è artistica, simbolica, educativa.

Una fotografia che mostra un capezzolo, un disegno anatomico, un progetto fotografico sul post-parto vengono oscurati, segnalati, bannati.

Mentre i contenuti pornografici, prodotti per il consumo maschile, vengono spinti, monetizzati, normalizzati.

Non è solo una questione di pelle nuda: è una questione di contesto e potere.

Non è la nudità a essere censurata: è la soggettività di chi si espone.

Quando una donna si fotografa secondo i propri codici, il sistema la considera “fuori norma”.

Quando lo fa per aderire a uno standard eterosessuale, la premia.

Il corpo femminile può essere visibile, ma solo se controllato.

Solo se consenziente al desiderio dominante.

Il risultato è un sistema che non distingue tra pornografia e rappresentazione artistica, che penalizza l’educazione e glorifica l’oggettificazione.

Un algoritmo che ha imparato — dai suoi creatori — che certe immagini vendono, altre disturbano.

E così, la narrazione digitale del corpo torna ad essere una proprietà da negoziare, non uno spazio da abitare.

Opacità e sfiducia: la censura senza volto

La censura digitale non ha più un volto. Non ha una firma, una legge, un decreto.

È un silenzio tecnico, un’interruzione del flusso, una sparizione senza spiegazioni.

E proprio per questo è così potente.

Le piattaforme non comunicano.

Non spiegano perché un contenuto è stato penalizzato, né offrono strumenti efficaci per fare ricorso.

Non c’è contraddittorio. Non c’è responsabilità.

Questo sistema opaco mina alla radice il patto di fiducia tra chi crea contenuti e chi fornisce lo spazio per farlo.

Chi lavora online — che sia educatorə, artistə, attivistə o imprenditorə indipendente — vive in una perenne condizione di incertezza.

Basta una parola mal interpretata, un’immagine fuori standard, un tema “troppo sensibile” per vedere anni di lavoro crollare.

Nel frattempo, le piattaforme si trincerano dietro la complessità tecnica, affermando che non è possibile “spiegare” l’algoritmo.

Ma quella complessità non è una giustificazione: è una forma di deresponsabilizzazione.

Dietro ogni contenuto oscurato, ogni account bloccato, ogni creator demonetizzato c’è una decisione politica mascherata da necessità tecnica.

E proprio perché non viene dichiarata come tale, è più pericolosa.

La mancanza di trasparenza produce censura strutturale, perché impedisce qualsiasi forma di opposizione organizzata.

Se non sai cosa hai fatto di sbagliato, non puoi difenderti.

Se non conosci le regole, non puoi nemmeno capire quando le hai violate.

Il discorso pubblico si restringe.

La creatività si autocensura.

La resistenza si stanca.

Educare online oggi: un lavoro che si paga caro

Fare educazione sessuale online è diventato un percorso a ostacoli.

Non perché manchino i contenuti, le competenze o il pubblico — ma perché l’ambiente digitale è ostile a chi prova a parlare di sessualità in modo onesto, consapevole, non conformista.

Le piattaforme non remunerano questo lavoro.

La pubblicità, principale fonte di guadagno per chi crea contenuti, è vincolata a criteri “family friendly” che escludono a priori tutto ciò che anche solo accenna al corpo, al piacere, al desiderio.

I contenuti vengono demonetizzati in automatico, anche quando trattano temi educativi o sanitari.

Il risultato?

Educatorə, divulgatorə, creator queer o femministə sono costrettə a cercare sponsor esterni — ma appena lo fanno, vengono accusatə di non essere indipendenti.

Se non monetizzi, non sopravvivi.

Se monetizzi, perdi credibilità.

Un vicolo cieco.

E mentre loro si barcamenano tra algoritmi ostili e comunità da nutrire, le piattaforme fanno profitti proprio grazie all’engagement che questi contenuti generano — senza restituire nulla a chi li crea.

Così, giorno dopo giorno, educare diventa più difficile, più faticoso, più solitario.

Molti smettono.

Altri resistono, ma a costo di burnout, precariato cronico, auto-censura.

La censura, in questo senso, non è solo un atto esplicito: è una strategia di logoramento.

Non ti vieta. Ti stanca. Ti svuota. Ti rende irrilevante.

E in questo svuotamento silenzioso, si perde un pezzo fondamentale del discorso pubblico: quello sull’affettività, sul consenso, sul corpo, sul piacere.

Un sapere fragile, ma essenziale. Che non si può lasciare scomparire.

Conclusione: resistere, creare, disobbedire

La censura non ha più bisogno di bandi, editti o proclami.

Oggi basta un algoritmo.

Un filtro opaco, automatico, inesorabile.

Non ti dice “non puoi parlare”, ti dice “non interessa a nessuno”.

Ti fa sparire. Ti lascia lì, a gridare nel vuoto.

E poi ti fa credere che è colpa tua.

Ma non lo è.

Non è colpa tua se parli di sesso con rispetto.

Se mostri un corpo non conforme.

Se usi parole nuove per dire chi sei.

Se insegni a distinguere il consenso.

Se mostri il piacere come diritto, e non come ricompensa.

La colpa non è del contenuto. È del sistema.

Un sistema che premia l’intrattenimento vuoto e punisce il pensiero.

Che amplifica l’odio e silenzia l’empatia.

Che monetizza la misoginia e penalizza l’educazione.

Ma non tutto è perduto.

C’è una forma di resistenza che è ancora possibile.

È la disobbedienza creativa.

È usare parole nuove, immagini nuove, strategie nuove.

È costruire comunità resilienti, intelligenti, solidali.

È non smettere di raccontare i corpi, i desideri, i margini.

Non c’è neutralità nella rete. Ma c’è spazio.

Spazio per immaginare altri modi di comunicare.

Spazio per dire quello che non si vuole sentire.

Spazio per essere liberi — anche se solo per pochi pixel alla volta.

Perché non possiamo lasciare che siano gli algoritmi a decidere cosa possiamo desiderare.

Link :

Instagram :

https://www.instagram.com/maestrobd2

https://www.youtube.com/@MaestroBD2